Ksapa travaille au quotidien sur les questions d’éthique et de respect des droits humains dans les entreprises de différents secteurs, partout dans le monde. En explorant chaque jour la manière dont les entreprises se digitalisent, intègrent les technologies dans leur mode de fonctionnement et de prestation de services, accroissent les applications portées par des systèmes dits d’intelligence artificielle, cela fait plus de 30 ans que nos experts observent les transformations exponentielles en marche. Il est désormais clair que l’ampleur et la diffusion de machines programmées pour imiter et exécuter des tâches qui nécessiteraient normalement l’intelligence humaine sont en train de bouleverser tous les aspects de l’entreprise, dans absolument tous les secteurs d’activité. Nous avons exploré un large éventail de techniques, d’algorithmes et de technologies qui permettent aux machines de percevoir, de raisonner, d’apprendre et de prendre des décisions. Dans un contexte de développements réglementaires comme la directive européenne EU AI Act, voici quelques enseignements que nous avons tirés pour encourager une démarche éthique de gestion des effets positifs tout en atténuant les risques que créent la généralisation de solutions portées par l’intelligence artificielle dans le fonctionnement des entreprises.

Comment les systèmes d’IA modifient-ils fondamentalement les opérations et les services des entreprises aujourd’hui ?

Les systèmes d’IA peuvent traiter de grandes quantités de données, reconnaître des modèles et extraire des informations pour effectuer des tâches telles que la résolution de problèmes, la prise de décision, le traitement du langage, la reconnaissance d’images et le fonctionnement autonome. Ils peuvent être conçus pour fonctionner selon des règles ou pour apprendre à partir de données grâce à des techniques d’apprentissage automatique.

L’IA comporte plusieurs sous-domaines, notamment

- L’apprentissage machine (ML) : L’apprentissage automatique consiste à former des machines à l’aide d’algorithmes pour apprendre à partir de données et améliorer leurs performances au fil du temps. Il permet aux machines de faire des prédictions, de classer des informations et de reconnaître des modèles sans être explicitement programmées.

- Apprentissage profond : L’apprentissage profond est un sous-ensemble de l’apprentissage automatique qui utilise des réseaux neuronaux artificiels inspirés du cerveau humain. Il s’agit de former des réseaux neuronaux profonds à plusieurs couches pour extraire automatiquement des représentations hiérarchiques des données, ce qui permet au système d’effectuer des tâches complexes telles que la reconnaissance d’images et de la parole.

- Traitement du langage naturel (NLP) : Le traitement du langage naturel vise à permettre aux machines de comprendre et de traiter le langage humain. Il comprend des tâches telles que la génération de langage, la traduction automatique, l’analyse des sentiments et les chatbots.

- Vision par ordinateur : La vision par ordinateur vise à permettre aux machines de percevoir et de comprendre les informations visuelles. Elle comprend des tâches telles que la reconnaissance d’images et de vidéos, la détection d’objets et la segmentation d’images.

- Robotique : La robotique associe l’IA à des machines physiques pour créer des systèmes autonomes ou semi-autonomes capables d’interagir avec le monde physique. Les systèmes robotiques peuvent effectuer des tâches telles que la manipulation d’objets, la navigation et les activités collaboratives.

L’IA a un large éventail d’applications dans divers secteurs et industries, notamment les soins de santé, la finance, les transports, l’agriculture, la fabrication, etc. Elle continue de progresser et a le potentiel de révolutionner de nombreux aspects de la société, en rendant les processus plus efficaces, en améliorant la prise de décision et en permettant de nouvelles capacités et de nouveaux services.

Quels sont les défis éthiques liés à l’utilisation de l’IA ?

L’utilisation de l’IA pose plusieurs problèmes éthiques qu’il convient de résoudre. Voici quelques considérations éthiques clés associées à l’IA :

- Préjugés et équité : Les systèmes d’IA peuvent, par inadvertance, hériter des préjugés des données sur lesquelles ils sont formés, ce qui entraîne des résultats biaisés et des discriminations. Il est essentiel de s’attaquer aux préjugés et de garantir l’équité des algorithmes et des décisions de l’IA pour éviter de perpétuer les inégalités sociétales. En central dans les entreprises, différents systèmes de recrutement en ligne et de premier traitement de dossiers de candidatures peuvent clairement poser ce type de problème. Différents services, par exemple marketing, peuvent également créer des systèmes de profiling de clients posant exactement le même type de problème.

- Protection de la vie privée et des données : L’IA repose souvent sur une collecte et une analyse approfondies des données, ce qui suscite des inquiétudes quant au respect de la vie privée et à la sécurité des informations personnelles. Il est essentiel de traiter les données de manière responsable, d’obtenir un consentement éclairé et de garantir des mesures de protection des données solides pour préserver la vie privée des individus. A mesure que les applications se dissémine sur des populations toujours moins éduquées ou sensibilisées (adolescents, consommateurs de pays émergents à très faible niveau d’éducation – pouvant par exemple ne pas dépasser l’école primaire), les considérations éthiques prennent ici des proportions gigantesques.

- Transparence et explicabilité : De nombreux systèmes d’IA, en particulier ceux alimentés par des techniques d’apprentissage profond, peuvent être très complexes et opaques. Le manque de transparence et d’explicabilité soulève des difficultés pour comprendre comment les systèmes d’IA parviennent à leurs décisions ou recommandations. Garantir la transparence et l’explicabilité est crucial pour instaurer la confiance et la responsabilité. Par exemple, on observe désormais dans différents processus industriels (construction d’équipement, efficacité énergétique) des systèmes de gestion de données dont les concepteurs eux-mêmes expliquent ne pas pouvoir prévoir et lire les décisions proposées par les machines.

- Responsabilité et obligation de rendre des comptes : À mesure que les systèmes d’IA deviennent plus autonomes, des questions se posent quant à savoir qui doit être tenu responsable de leurs actions et des dommages qu’ils peuvent causer. Déterminer la responsabilité juridique et éthique lorsque les systèmes d’IA prennent des décisions ou adoptent un comportement autonome est un défi permanent. Par exemple, en travaillant dans le secteur automobile et de la mobilité, on observe que le développement de conduite assistée voire « autonome » implique de considérer la gestion des accidents. Si un système de conduite géré par IA fait un accident, comment rendre compte de qui est alors responsable de quoi? Le conducteur? Le constructeur automobilie? Le concepteur du dispositif de conduite assisté par IA?

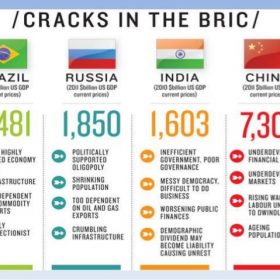

- Impact sur l’emploi et les disparités socio-économiques : L’adoption des technologies de l’IA a le potentiel de perturber les rôles professionnels traditionnels et de créer des disparités socio-économiques. Il est important de tenir compte de l’impact sur l’emploi, d’envisager des initiatives de requalification et d’amélioration des compétences, et de veiller à ce que l’IA profite à tous les membres de la société. De nombreux métiers sont ainsi menacés de disparition si ils ne sont pas capables de monter en haute valeur ajoutée. La traduction par exemple peut conserver une dimension humaine seulement dans la gestion de cas assermentés, ou dans des situations de litiges techniques complexes exigeant une interprétation de haute technicité, là où la traduction de contrats et documents plus simples se banalise et les traducteurs disparaissent au profit de machines.

- Supervision et contrôle humains : Les systèmes d’IA devraient être conçus pour renforcer les capacités humaines plutôt que pour remplacer entièrement le jugement humain. Il est essentiel d’assurer une surveillance et un contrôle humains appropriés des systèmes d’IA afin d’éviter les conséquences imprévues et de préserver l’action humaine. Par exemple, dans le domaine de la santé, l’IA apporte une capacité de calcul et de reconnaissance de typologies médicales extrêmement avancées. Pour autant, de la probabilité au diagnostic médical, il reste indispensable de s’assurer qu’un regard humain expert porte la décision ultime.

- Conséquences imprévues et risques : Les systèmes d’IA peuvent avoir des comportements inattendus ou commettre des erreurs qui ont des conséquences importantes. Il est essentiel de comprendre et de gérer les risques potentiels, y compris ceux liés à la sûreté, à la sécurité et à l’impact sociétal, pour atténuer les dommages et garantir un déploiement responsable de l’IA. Par exemple, différents dispositifs de reconnaissance biométriques ont démontré des failles importantes, qu’il convient de corriger avec là encore des boucles humaines et interdisciplinaires permettant d’apprendre des erreurs et corriger les risques d’imprévus.

- Prise de décision éthique : Les systèmes d’IA peuvent être confrontés à des situations où des dilemmes éthiques se posent, nécessitant la capacité de prendre des décisions éthiques. Déterminer comment les systèmes d’IA doivent donner la priorité à des valeurs contradictoires ou naviguer dans des situations moralement ambiguës est un défi complexe. Par exemple, dans l’armement, certaines technologies permettent d’autonomiser la décision de tir (et de tuer) donnée à la machine en quand de probabilité forte de réussite de mission, tout en réduisant les pertes humaines. Là encore, des choix mettant en balance des vies humaines qu’on peut retrouver dans des domaines comme la santé, le sanitaire, ou l’éducation exigent de s’assurer qu’une boucle de gouvernance humaine garde la main et soit comptable des décisions.

Relever ces défis éthiques nécessite une collaboration interdisciplinaire entre les chercheurs en IA, les décideurs politiques, les éthiciens, les acteurs de l’industrie et le grand public. L’élaboration de cadres éthiques, de lignes directrices et de réglementations solides, ainsi que la promotion de la transparence, de la responsabilité et de l’inclusion dans le développement et le déploiement de l’IA, sont essentielles pour que les systèmes d’IA soient responsables et dignes de confiance.

10 principes pour atténuer les risques éthiques liés à l’utilisation de l’IA dans les entreprises

Ksapa a exploré ces risques éthiques à travers une grande variété d’applications commerciales et de zones géographiques. Pour atténuer les risques éthiques associés à l’IA dans les applications professionnelles, plusieurs principes et bonnes pratiques peuvent être suivis. Voici quelques principes clés que nous avons appris et que nous appliquons à travers nos outils et méthodologies chez Ksapa, et qui peuvent aider à guider un déploiement responsable de l’IA :

- Transparence : Favoriser la transparence des systèmes d’IA en fournissant des explications claires sur leur fonctionnement, y compris leurs processus de prise de décision et leurs limites potentielles. Communiquez ouvertement sur les sources de données, les algorithmes utilisés et tous les biais ou incertitudes impliqués.

- Équité et atténuation des préjugés : S’efforcer d’assurer l’équité des systèmes d’IA en s’attaquant activement aux préjugés et à la discrimination. Évaluer et atténuer régulièrement les biais dans les données, les algorithmes et les modèles afin de garantir des résultats équitables pour les différents groupes démographiques.

- Protection de la vie privée et des données : Respecter le droit à la vie privée et protéger les données sensibles des utilisateurs. Recueillir et traiter les données de manière responsable, en veillant à respecter les réglementations pertinentes en matière de protection de la vie privée et à obtenir un consentement éclairé. Mettre en œuvre des mesures de sécurité solides pour protéger les données.

- Responsabilité et contrôle humain : Mettre en place des mécanismes de contrôle humain et de responsabilité dans les systèmes d’IA. Les humains devraient avoir la possibilité d’intervenir, de contester ou d’annuler les décisions générées par l’IA si nécessaire. Définir clairement les rôles et les responsabilités des opérateurs humains et des technologies d’IA.

- Une gouvernance solide : Mettre en œuvre des cadres de gouvernance efficaces pour le développement et le déploiement de l’IA. Il s’agit d’établir des politiques, des lignes directrices et des procédures internes qui tiennent compte des considérations éthiques, de la gestion des risques et du respect des lois et réglementations applicables.

- Évaluation et atténuation des risques : Effectuer des évaluations complètes des risques afin d’identifier et de traiter les risques éthiques, juridiques et sociétaux potentiels associés à la mise en œuvre de l’IA. Identifier et atténuer de manière proactive toute conséquence néfaste ou involontaire.

- Conception centrée sur l’utilisateur : Donner la priorité au bien-être et aux intérêts de l’utilisateur lors de la conception des systèmes d’IA. Incorporez les commentaires des utilisateurs, effectuez des tests auprès d’eux et veillez à ce que les technologies d’IA correspondent à leurs besoins et à leurs attentes.

- Prise de décision éthique : Développer des systèmes d’IA capables de prendre des décisions éthiques en intégrant des principes éthiques dans leur conception. Envisager le développement de systèmes d’IA capables d’expliquer leurs décisions et de s’engager dans un raisonnement éthique.

- Collaboration et diversité : Encourager la collaboration interdisciplinaire et la diversité des points de vue dans le développement et le déploiement des systèmes d’IA. Inclure la contribution d’éthiciens, de spécialistes des sciences sociales, d’experts du domaine et de parties prenantes afin de garantir une approche globale et équilibrée.

- Contrôle et amélioration continus : Contrôler et évaluer régulièrement les systèmes d’IA afin d’évaluer leur impact éthique et leurs performances. Mettre en place des boucles de rétroaction et des mécanismes d’amélioration continue, en tenant compte des préoccupations éthiques et en s’adaptant à l’évolution du contexte.

L’adhésion à ces principes peut aider les organisations à relever les défis éthiques associés à l’IA dans les applications professionnelles, à promouvoir des pratiques d’IA responsables et à renforcer la confiance des utilisateurs, des employés et du grand public.

Par ailleurs, dans ce secteur en constante évolution, différents acteurs produisent régulièrement des réflexions dont le travail mérite attention particulière, notamment : European Digital Rights (EDRi), Access Now, AlgorithmWatch, All Out, Amnesty International, Article 19, Aspiration, Border Violence Monitoring Network, Center for AI and Digital Policy (CAIDP), DataEthics.eu, Digital Defenders Partnership, Equinox Initiative for Racial Justice, European Center for Not-for-Profit Law Stichting, European Civic Forum, European Disability Forum, European Network Against Racism (ENAR), European Network on Religion and Belief, European Network on Statelessness, FIDH, Future of Life Institute, Hivos, Human Rights Watch, JustX, World Organization for Early Childhood Education, Ligue des Droits de l’Homme, La Quadrature du Net, Open Knowledge Foundation, OpenMedia, Partnership on AI, Privacy International, Ranking Digital Rights, Worker Info Exchange.

Ksapa, basée à Paris, en France, avec des bureaux à Londres et à New York, est une plateforme mondiale de premier plan qui peut aider votre entreprise à mettre en œuvre les enseignements de cet article. Travaillant avec un grand nombre d’investisseurs et d’entreprises parmi les plus influents, Ksapa s’appuie sur un réseau de plus de 150 experts répartis en Europe, en Amérique du Nord et en Amérique latine, en Afrique et en Asie du Sud-Est. N’hésitez pas à nous contacter pour bénéficier de nos services et gérer ces enjeux complexes le plus efficacement possible.

Président et Cofondateur. Auteur de différents ouvrages sur les questions de RSE et développement durable. Expert international reconnu, Farid Baddache travaille à l’intégration des questions de droits de l’Homme et de climat comme leviers de résilience et de compétitivité des entreprises. Restez connectés avec Farid Baddache sur Twitter @Fbaddache.

-

Farid Baddache

-

Farid Baddache

-

Farid Baddache

-

Farid Baddache

-

Farid Baddache

-

Farid Baddache15 novembre 2024

-

Farid Baddache23 septembre 2023

-

Farid Baddache

-

Farid Baddache

-

Farid Baddache

-

Farid Baddache

-

Farid Baddache

-

Farid Baddache

-

Farid Baddache

-

Farid Baddache

-

Farid Baddache

-

Farid Baddache

-

Farid Baddache

-

Farid Baddache

-

Farid Baddache

-

Farid Baddache

-

Farid Baddache

-

Farid Baddache

-

Farid Baddache

-

Farid Baddache18 septembre 2018

Christian intervient chez Ksapa en qualité de Directeur des Solutions Numériques. Christian a 20 ans d’expérience professionnelle dans le secteur informatique, après avoir exercé différentes positions en développement et vente de solutions au sein d’IBM France, Metamerge A/S (Norvège) et du Centre National Etudes Spatiales.

En reconversion et désireux de renforcer la contribution de ses projets à l’intérêt général, Christian a récemment suivi un Executive Masters aux Mines ParisTech/ISIGE.

Christian parle français, anglais, serbe, espagnol et russe.

-

Christian Châteauvieux

-

Christian Châteauvieux

-

Christian Châteauvieux11 septembre 2023